OneAPI-开源的AI模型接口管理和分发神器

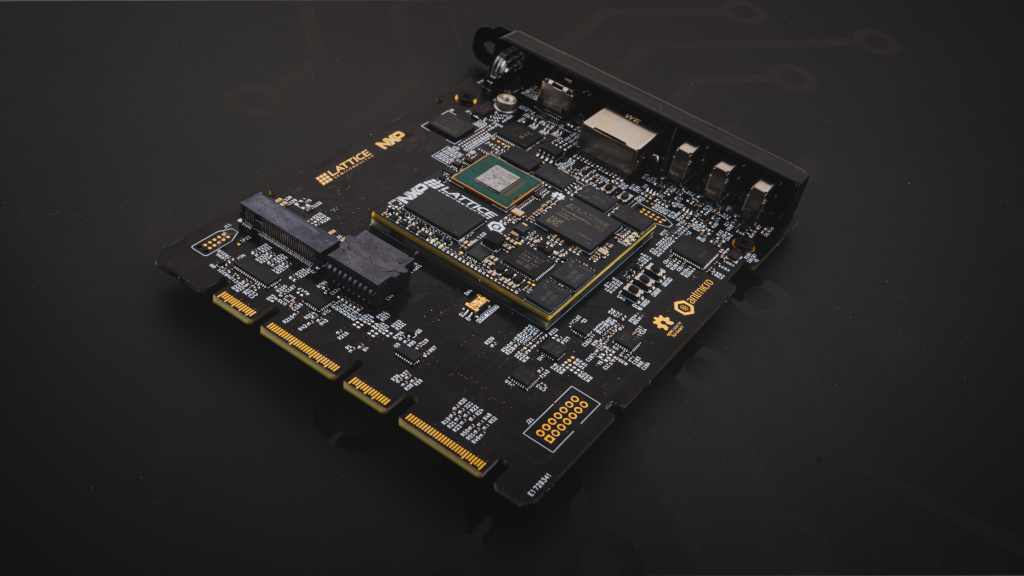

OneAPI 是一个开源的 AI 模型接口管理和分发神器,它能将所有大模型一键封装成 OpenAI 协议,这样你就可以薅各大厂家的 AI 免费羊毛了。

OneAPI 统一了接口协议,其他的第三方服务,如 ChatGPT Next Web,就可以很方便的使用各种模型了。

开源地址:https://github.com/songquanpeng/one-api

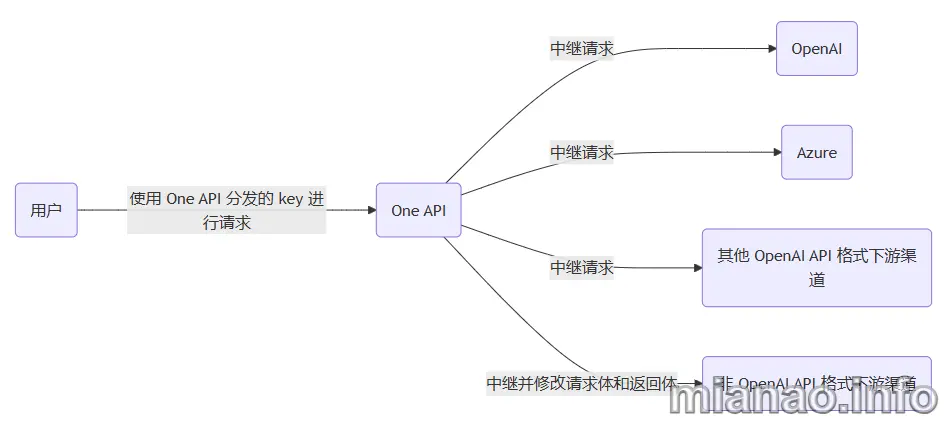

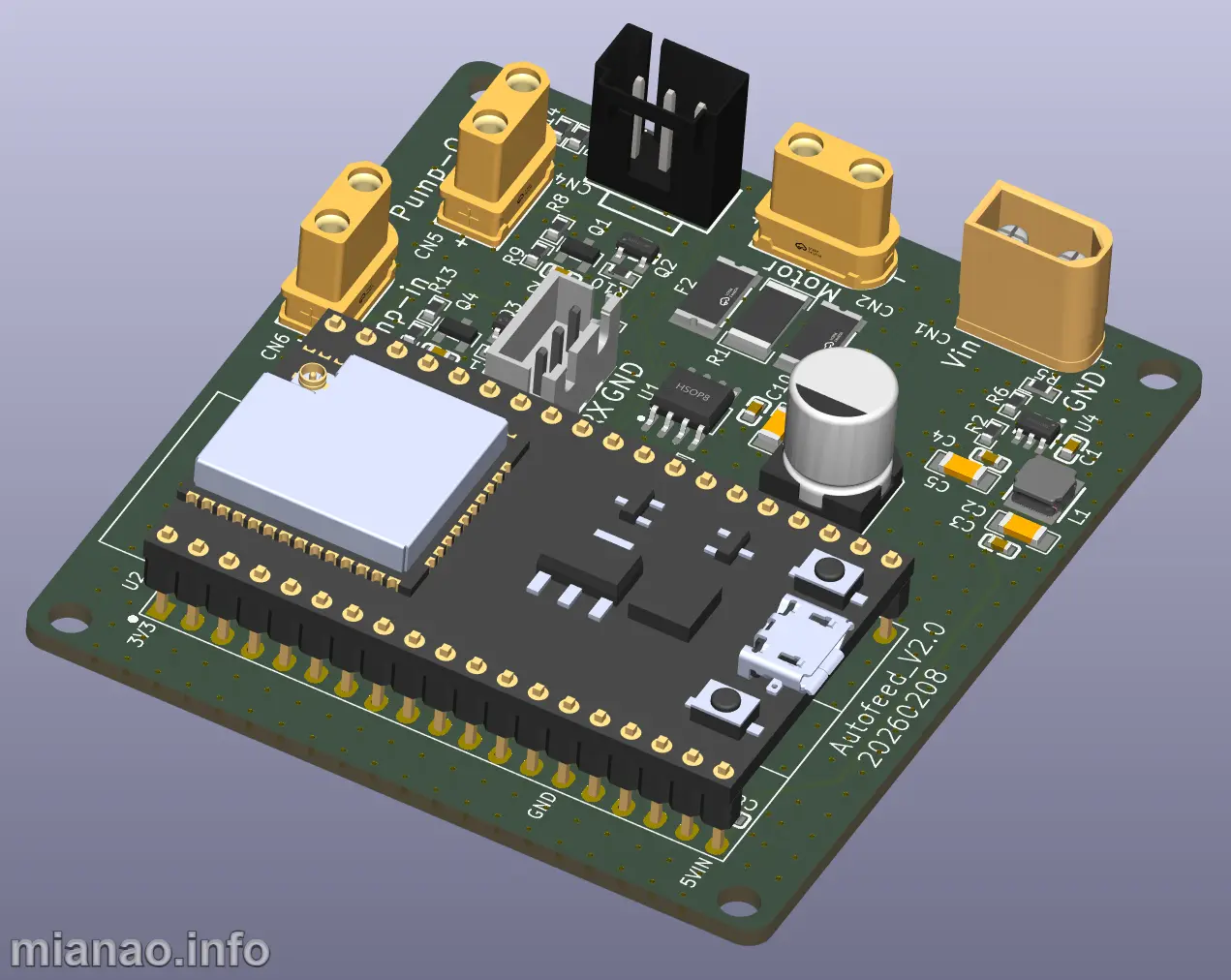

原理框图:

目前支持这些大模型:

- OpenAI ChatGPT 系列模型(支持 Azure OpenAI API)

- Anthropic Claude 系列模型 (支持 AWS Claude)

- Google PaLM2/Gemini 系列模型

- Mistral 系列模型

- 字节跳动豆包大模型

- 百度文心一言系列模型

- 阿里通义千问系列模型

- 讯飞星火认知大模型

- 智谱 ChatGLM 系列模型

- 360 智脑

- 腾讯混元大模型

- Moonshot AI

- 百川大模型

- MINIMAX

- Groq

- Ollama

- 零一万物

- 阶跃星辰

- Coze

- Cohere

- DeepSeek

- Cloudflare Workers AI

- DeepL

- together.ai

- novita.ai

- 硅基流动 SiliconCloud

- xAI

具体怎么部署,搜一下教程有很多,我就不写了:

注意点有两个:

1.一般来说都是基于 Docker Compose 进行部署,如果是在服务器上用域名访问的话,需要对 Nginx 配置,有两个地方要修改:

- 添加:

1 | server |

- 删除:

1 | server |

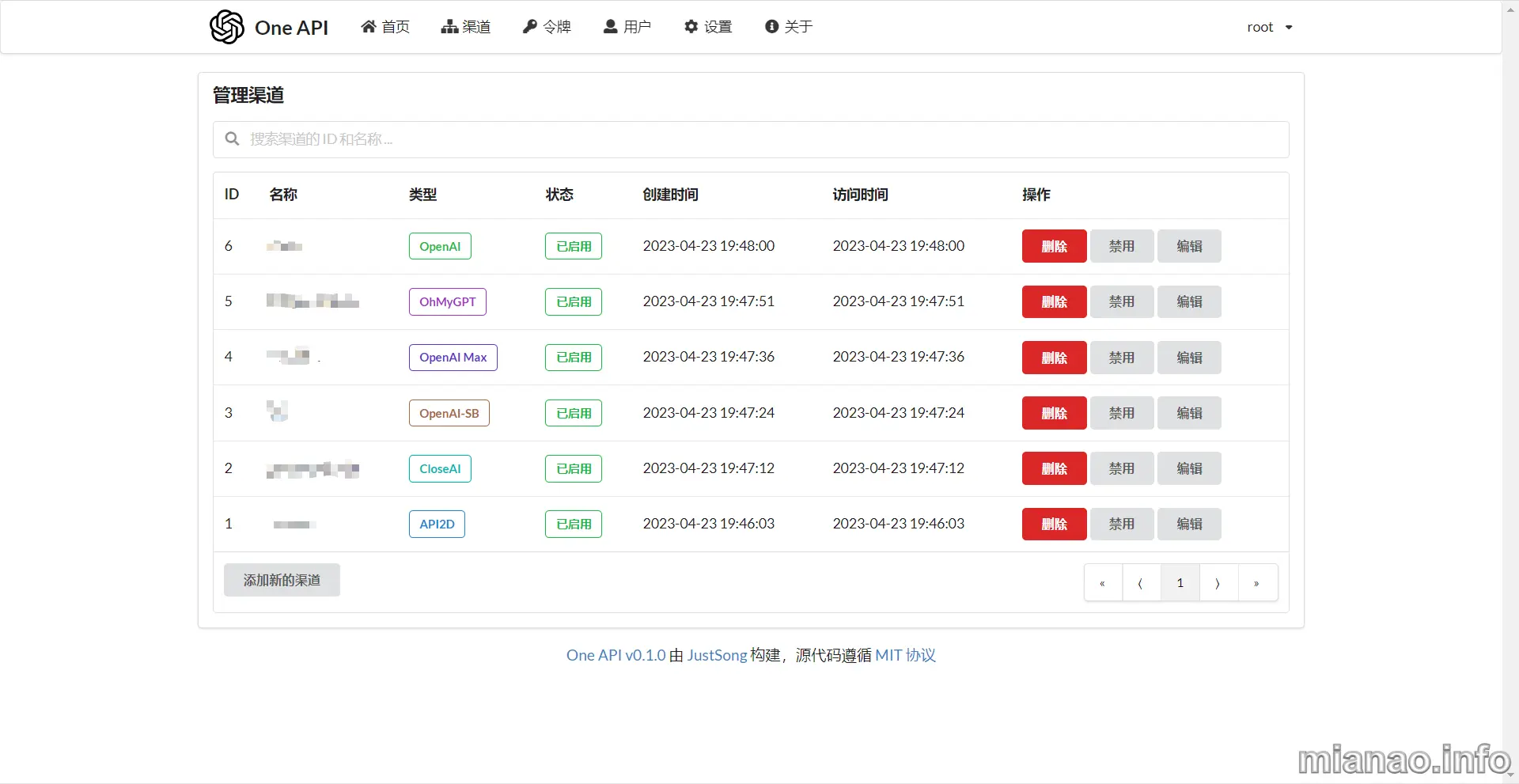

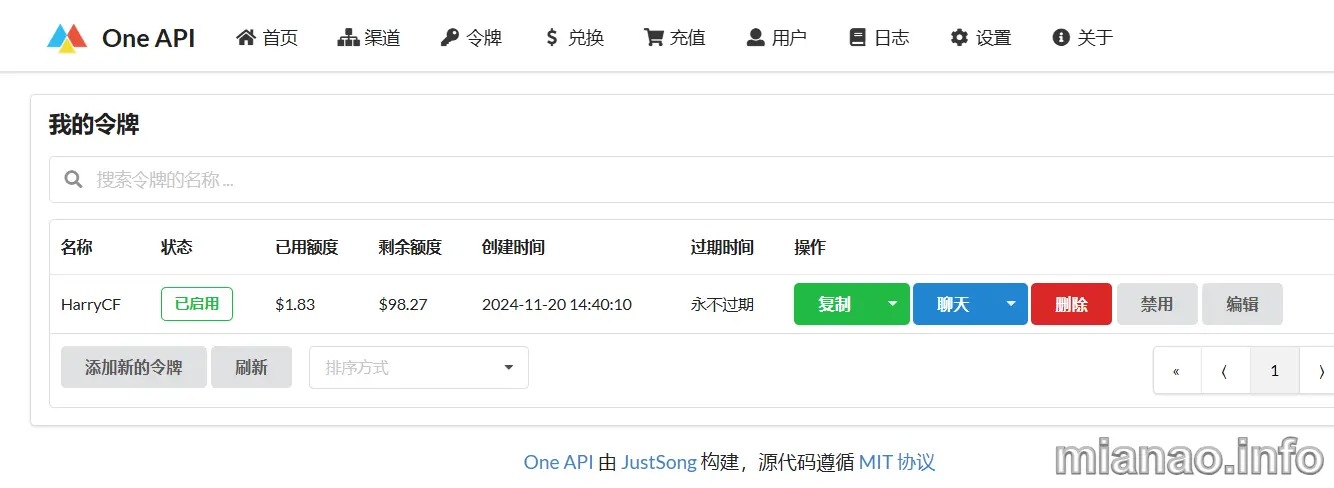

部署完成后访问就是添加渠道,添加令牌了,不多说。

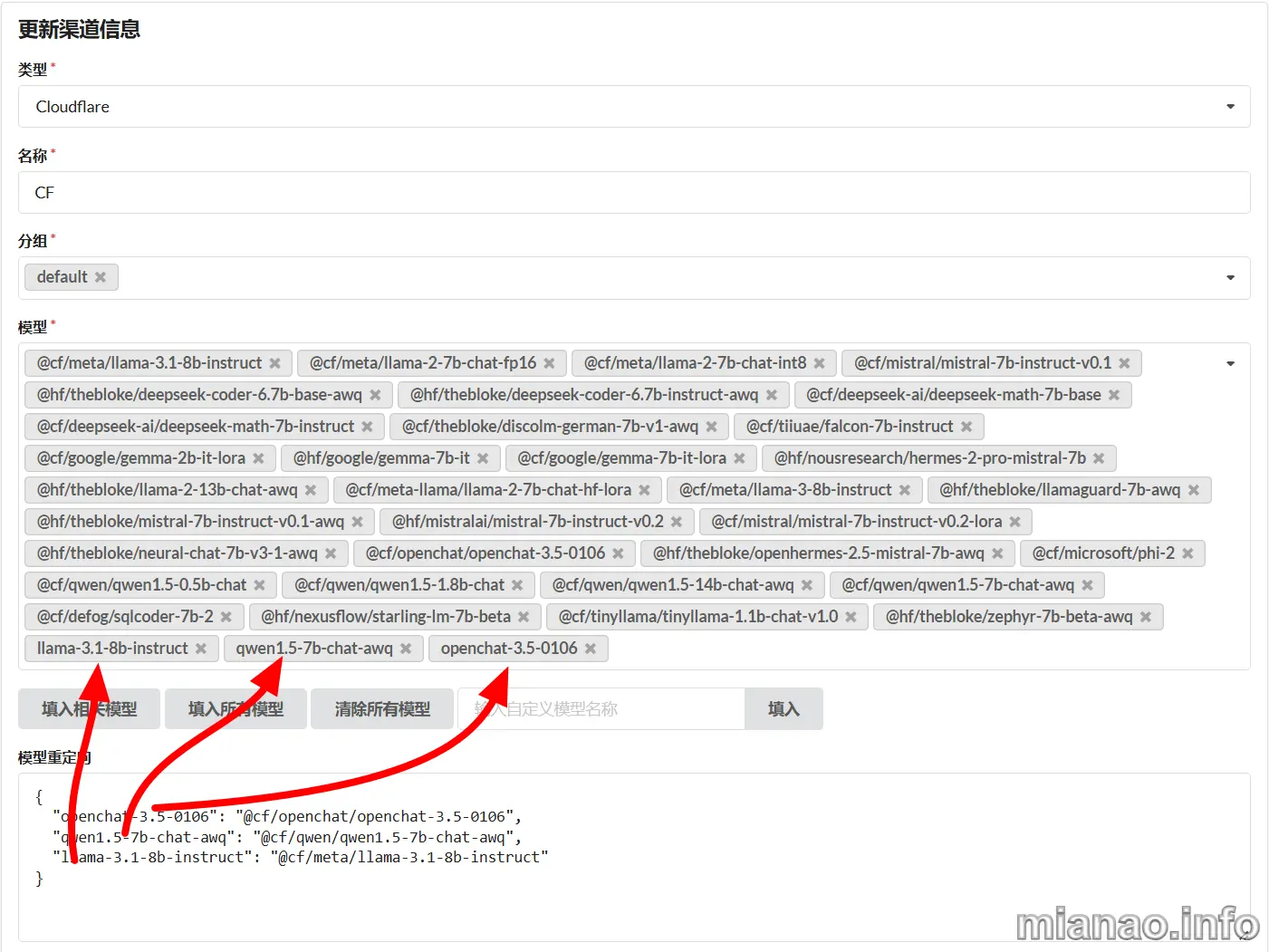

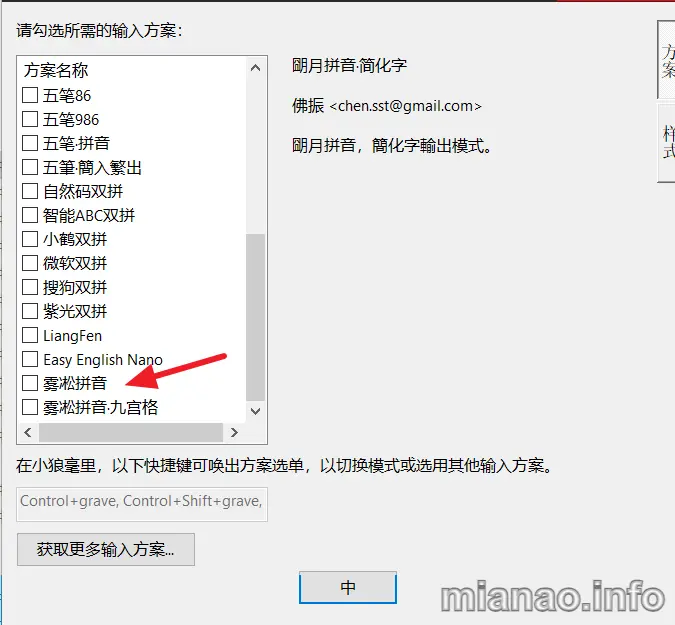

2.有一些免费的渠道,比如 Gemini,Groq,Cloudflare 等等,直接添加就可以用了,但我在用 Cloudflare 时遇到了问题,可以看到他的模型名称:

- @cf/deepseek-ai/deepseek-math-7b-instruct

- @cf/defog/sqlcoder-7b-2

- @cf/fblgit/una-cybertron-7b-v2-awq

- @cf/fblgit/una-cybertron-7b-v2-bf16

- @cf/google/gemma-2b-it-lora

- @cf/google/gemma-7b-it-lora

- @cf/meta-llama/llama-2-7b-chat-hf-lora

- @cf/meta/llama-2-7b-chat-fp16

等等,都是 @cf 开头,有一些第三方平台就不支持,这时就需要自定义模型名称了。

模型重定向里面,自定义名称写前面,原始名称写后面,而且还要把自定义的名称添加到模型里面。

用下面这个 API CHECK 时,自定义的模型会显示未匹配,是可用但不一致的模型。

https://github.com/october-coder/api-check

推荐 Vultr:我已使用超过 9 年觉得还算稳定可靠的便宜 VPS,虽然可能会有 IP 被墙,但欧美亚的机房可以随便切换。

奖励链接: 欢迎使用推荐链接,新用户充值有奖励 https://www.vultr.com/?ref=7342510

奖励链接: 欢迎使用推荐链接,新用户充值有奖励 https://www.vultr.com/?ref=7342510

评论